FlowiseAI RAG chat

FlowiseAI es una herramienta de bajo código para desarrolladores para construir flujos de orquestación LLM personalizados y agentes AI. Puede configurar la herramienta FlowiseAI para utilizar nodos Gaia como proveedores de servicios LLM.

Requisitos previos

Necesitará un nodo Gaia preparado para proporcionar servicios LLM a través de una URL pública. Puede

En este tutorial, utilizaremos nodos públicos para alimentar el plugin Continue.

| Tipo de modelo | URL base de la API | Nombre del modelo |

|---|---|---|

| Chat | https://llama8b.gaia.domains/v1 | llama |

| Inserción | https://llama8b.gaia.domains/v1 | nomic |

Iniciar un servidor FlowiseAI

Siga la guía FlowiseAI para instalar Flowise localmente

npm install -g flowise

npx flowise start

Después de ejecutarlo con éxito, puede abrir http://localhost:3000 para comprobar la herramienta Flowise AI.

Crear un chatbot de preguntas y respuestas sobre documentos

FlowiseAI le permite configurar visualmente todos los componentes del flujo de trabajo para un agente de IA. Si eres nuevo en FlowiseAI, se recomienda utilizar una plantilla de inicio rápido. De hecho, hay un montón de plantillas alrededor de OpenAI en el marketplace de Flowise. Todo lo que necesitamos hacer es reemplazar el componente ChatOpenAI por el componente ChatLocalAI.

Tomemos como ejemplo Flowise Docs QnA. Puede crear un chatbot QnA basado en sus documentos. En este ejemplo, nos gustaría chatear con un conjunto de documentos en un repositorio de GitHub. La plantilla por defecto fue construida con OpenAI y ahora la cambiaremos para usar un LLM de código abierto en un nodo Gaia.

Consiga laplantilla QnA de Flowise Docs

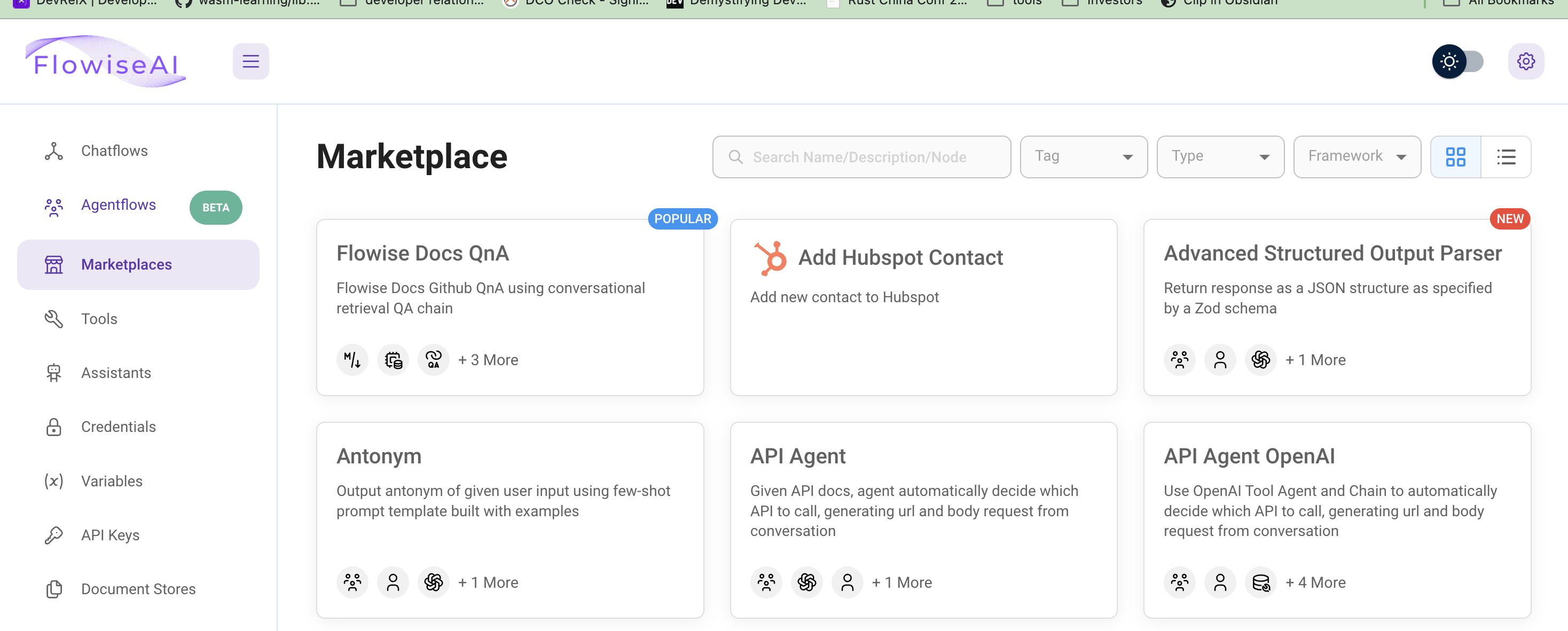

Haga clic en Marketplaces en la pestaña de la izquierda para examinar todas las plantillas. La plantilla Flowise Docs QnA que utilizaremos es la primera.

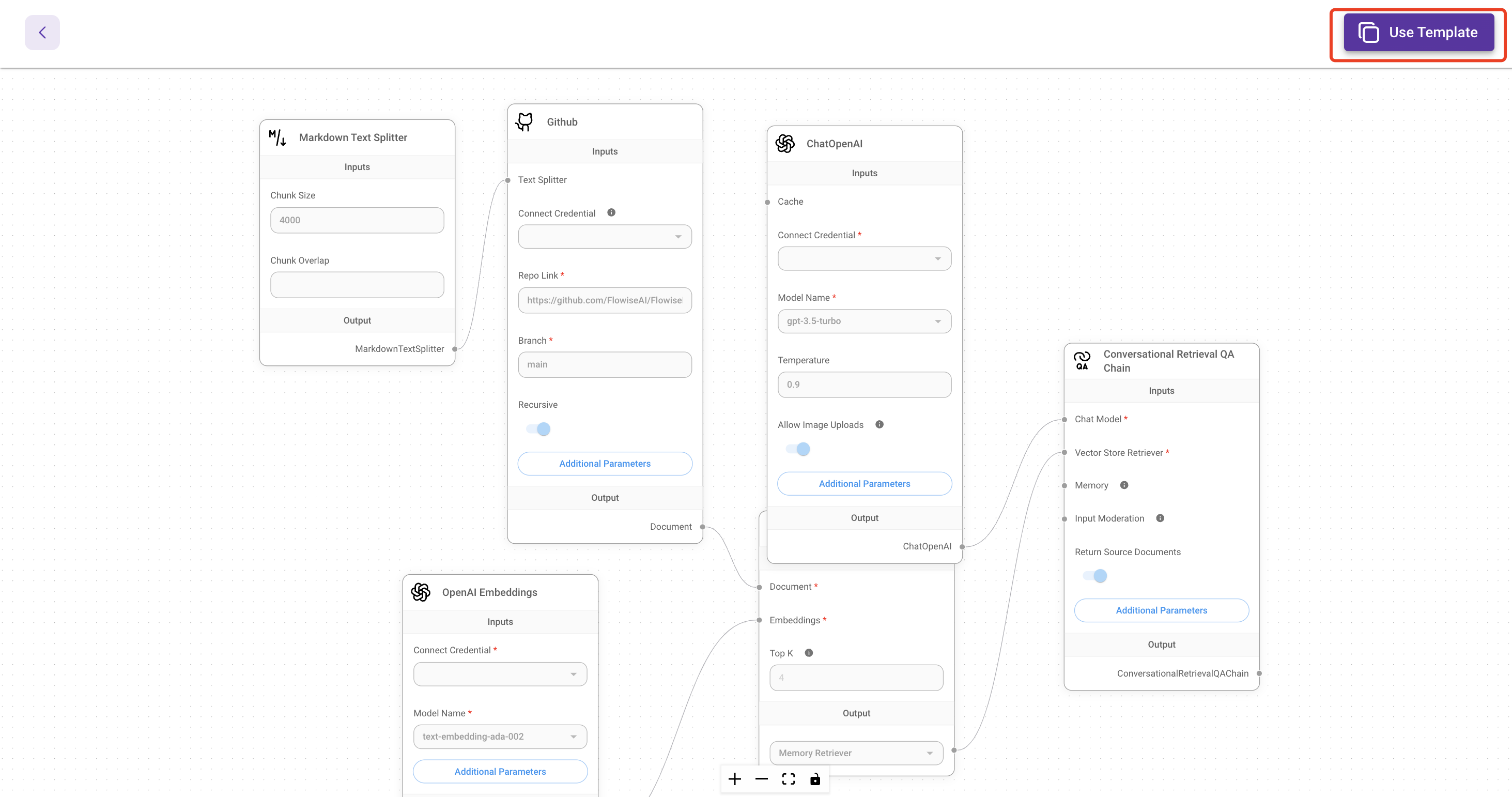

A continuación, haga clic en el botón Utilizar esta plantilla situado en la esquina superior izquierda para abrir el editor visual.

Conectar la API del modelo de chat

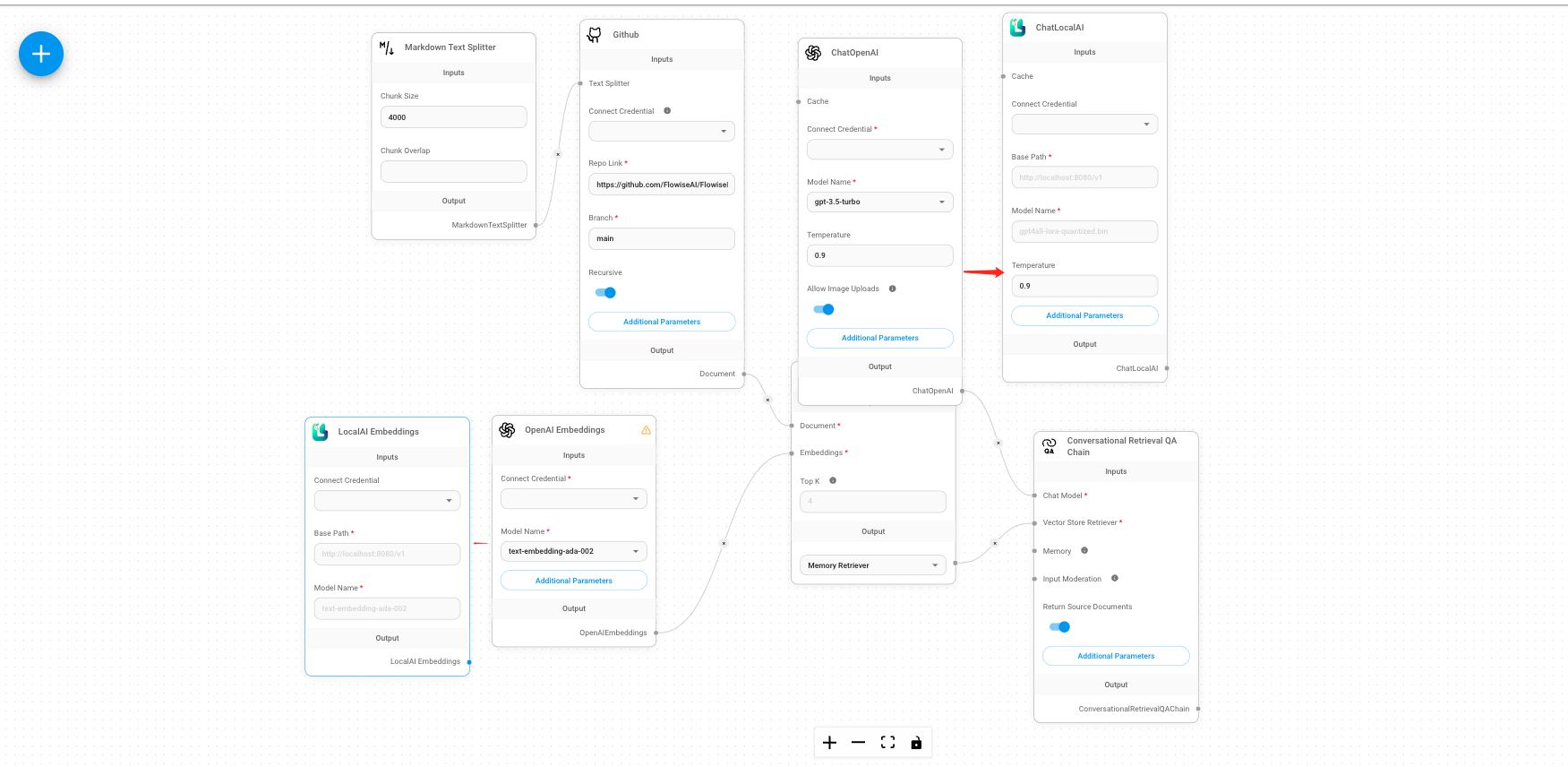

Deberá eliminar el componente ChatOpenAI y hacer clic en el botón + para buscar ChatLocalAI y, a continuación, arrastrar ChatLocalAI a la pantalla.

A continuación, deberá introducir

- la URL base del nodo Gaia

https://llama8b.gaia.domains/v1 - el nombre del modelo

llama

A continuación, conecte el componente ChatLocalAI con el campo Modelo de chat en el Cadena de control de calidad de la recuperación conversacional componente.

Conectar la API del modelo de incrustación

La plantilla por defecto utiliza el componente OpenAI Embeddings para crear incrustaciones para sus documentos. Tenemos que sustituir el componente OpenAI Embeddings por el componente LocalAI Embeddings.

- Utiliza la URL base del nodo Gaia

https://llama8b.gaia.domains/v1en el campo Ruta base. - Introduzca el nombre del modelo

nomic-embed-text-v1.5.f16en el campo Nombre del modelo.

A continuación, conecte el Incrustaciones LocalAI con el campo incrustación en el Almacén vectorial en memoria componente.

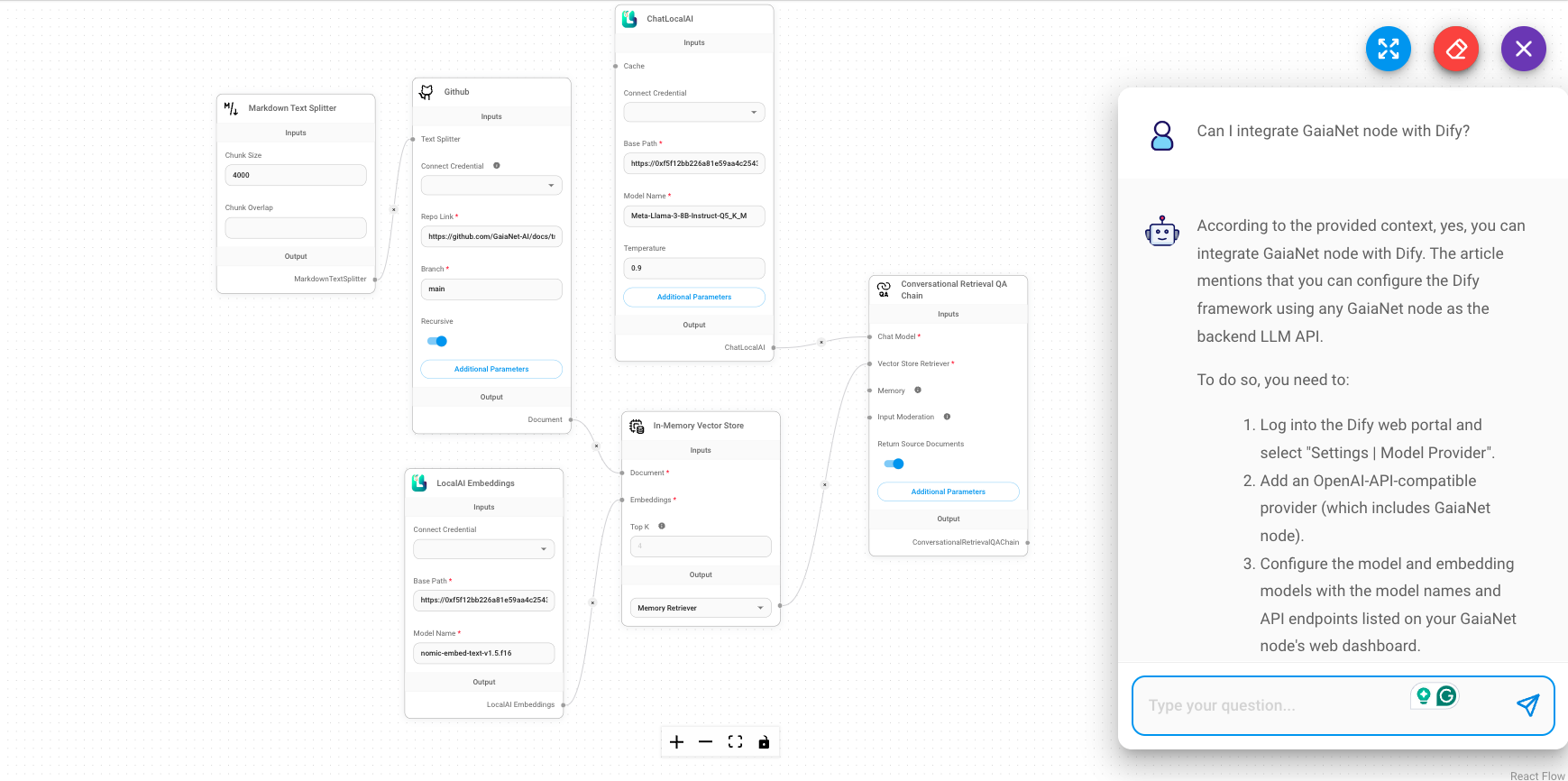

Configure sus documentos

A continuación, vamos a pasar por el componente GitHub para conectar la aplicación de chat a nuestros documentos en GitHub. Usted tendrá que poner su docs GitHub enlace en el Enlace Repo campo. Por ejemplo, puedes poner el enlace docs de Gaia: https://github.com/GaiaNet-AI/docs/tree/main/docs.

Pruébalo

Puedes enviar una pregunta como "Cómo instalar un nodo de Gaia" después de guardar el chatflow actual.

Obtendrás la respuesta basándote en los documentos de Gaia, que son más precisos.

Más ejemplos

Hay muchos ejemplos en el marketplace de Flowise. Para construir un agente Flowise basado en Gaia, simplemente reemplaza el componente Chat OpenAI y OpenAI Embeddings con la URL base de Gaia.