LlamaCloud

LlamaParse es una API creada por LlamaIndex para analizar y representar archivos de forma eficiente para una recuperación eficaz y un aumento del contexto utilizando marcos LlamaIndex. LlamaParse admite diferentes tipos de archivos, como pdf, doc, .ppt y otros formatos.

Puede configurar LlamaParse para utilizar el nodo Gaia como backend LLM, por lo que puede crear una aplicación RAG basada en sus archivos PDF localmente.

Requisitos previos

Necesitará un nodo Gaia preparado para proporcionar servicios LLM a través de una URL pública. Puede

En este tutorial, utilizaremos nodos públicos para alimentar el plugin Continue.

| Tipo de modelo | URL base de la API | Nombre del modelo |

|---|---|---|

| Chat | https://llama8b.gaia.domains/v1 | llama |

| Inserción | https://llama8b.gaia.domains/v1 | nomic-embed |

Pasos

Utilizaremos un repositorio de GitHub de código abierto, llamado llamaparse-integraciónpara que LlamaPase sea fácil de usar. El sitio llamaparse-integración aplicación compatible

- Múltiples formatos de archivo, como

.pdfy.doc, - Varios archivos

Primero necesitaremos tener el código fuente en tu terminal.

git clone https://github.com/alabulei1/llamaparse-integration.git

cd llamaparse-integración

A continuación, instale los paquetes de modo necesarios.

npm install llamaindex

npm install dotenv

Iniciar una instancia Qdrant. La instancia Qdrant es para almacenar las incrustaciones.

mkdir qdrant_storage

mkdir qdrant_snapshots

nohup docker run -d -p 6333:6333 -p 6334:6334 \

-v $(pwd)/qdrant_storage:/qdrant/storage:z \

-v $(pwd)/qdrant_snapshots:/qdrant/snapshots:z \

qdrant/qdrant

A continuación, tendremos que configurar los ajustes del modelo LLM. Podemos configurar el ajuste del modelo en el .env archivo.

OPENAI_BASE_URL=https://llama8b.gaia.domains/v1/

OPENAI_API_KEY=gaianet

LLAMAEDGE_CHAT_MODEL=llama

LLAMAEDGE_EMBEDDING_MODEL=nomic

LLAMA_CLOUD_API_KEY=Tu_Propia_KEY

FILE_PATH=

FILE_DIR=./pdf_dir

COLLECTION_NAME=por defecto

QDRANT_URL=http://127.0.0.1:6333

SAVE_MARKDOWN_PATH=salida.md

He aquí algunas notas sobre el .env ajuste:

- Puedes obtener la clave de LlamaCloud en https://cloud.llamaindex.ai

- Es posible que tenga que hacer cambios según la configuración de su modelo y la ruta del archivo.

- Si pone el nombre del archivo en el campo

FILE_PATH=el programa creará una aplicación RAG con este único archivo pdf. - Si el

FILE_PATH=está vacío, el programa creará una aplicación RAG con los archivos que se encuentren bajo el directorioFILE_DIR=./dir_pdf. Puede incluir varios archivos en la carpeta.

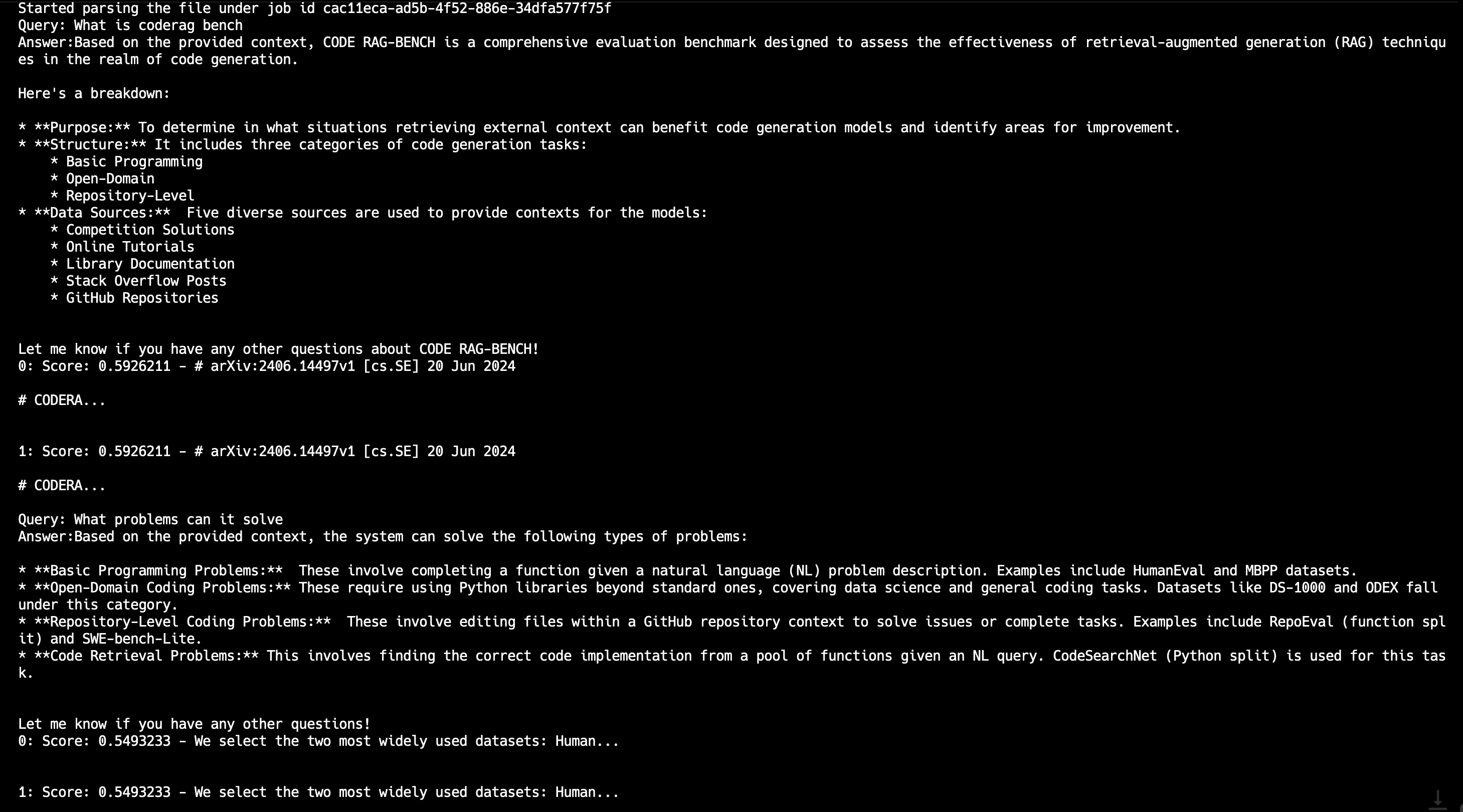

A continuación, podemos ejecutar el programa para crear una aplicación RAG basada en el archivo PDF

npx tsx pdfRender.ts

Después de que se ejecute correctamente, puede enviar una consulta a través de la línea de comandos.